NeurIPS 2019

摘要

Reinforcement Learning (RL) algorithms typically require millions of environment interactions to learn successful policies in sparse reward settings. Hindsight Experi-ence Replay (HER) was introduced as a technique to increase sample efficiency by reimagining unsuccessful trajectories as successful ones by altering the originally intended goals. However, it cannot be directly applied to visual environments where goal states are often characterized by the presence of distinct visual features. In this work, we show how visual trajectories can be hallucinated to appear successful by altering agent observations using a generative model trained on relatively few snapshots of the goal. We then use this model in combination with HER to train RL agents in visual settings. We validate our approach on 3D navigation tasks and a simulated robotics application and show marked improvement over baselines derived from previous work.

强化学习(RL)算法通常需要数以百万计的环境互动来学习稀疏奖励环境下的成功策略。Hindsight Experience Replay(HER)被作为一种技术引入,通过改变最初的目标,将不成功的轨迹重新想象成成功的轨迹,从而提高采样效率。然而,它不能直接应用于视觉环境,因为在视觉环境中,目标状态往往是由明显的视觉特征来表征的。在这项工作中,我们展示了视觉轨迹是如何成功应用的,通过改变智能体的观察,用一个在相对较少的目标快照上训练出来的生成模型。然后,我们将这个模型与HER结合起来,在视觉环境中训练RL智能体。我们在三维导航任务和模拟机器人应用中验证了我们的方法,并表现出比以前的工作中得出的基线有明显的改进。

研究动机

- 大部分探索的轨迹并不产生学习信号,希望最小化环境交互的数量

- 仅使用稀疏奖励进行训练

- 在视觉环境中,目标状态无法被其他状态直接表示,需要对智能体的观测进行修改

(任务为搜索随机放置在周围的鹅卵石并靠近。上图表示原轨迹;下图表示相同轨迹,但使用HALGAN对观测进行修改,使最终状态鹅卵石被成功收集)

主要贡献

扩大HER在视觉领域的适用性,提供一种方法将失败的视觉轨迹逆向转化为成功的轨迹

- 主要表现于,原始HER的目标状态可以直接用轨迹中某一帧表示,而视觉环境中,需要对整个轨迹的观测进行重构(即添加目标相关图像信息)

方法描述

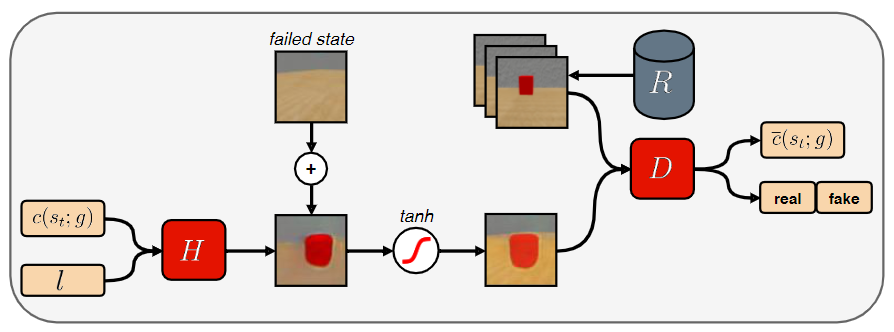

Minimal Hallucinations of Visual Goals 视觉目标最小幻觉 (HALGAN的几个loss)

获取幻觉图片:$\overline{s_{t}}=\operatorname{Tanh}\left(s_{t}+H\left(c\left(s_{t} ; s_{T}\right), l\right)\right)$

- $c\left(s_{t} ; g\right)$:机器人与预期目标状态的相对配置(没太明白这个"relative configuration"具体怎么表示,后文提及 $c\left(s_{t} ; g\right) \in \mathbb{R}^n$)

- $l$:随机潜在条件向量(就是一个噪声?)

判别网络Loss:$L_{D}=\mathbb{E}_{\overline{s_{t}} \sim p_{H}}\left[\log D\left(\overline{s_{t}}\right)\right]-\mathbb{E}_{s_{r} \sim p_{R}}\left[\log \left(D\left(s_{r}\right)\right)\right]$

- $R$:dataset

- 训练Wasserstein GANs的梯度Loss:$L_{\nabla}=\mathbb{E}_{\hat{s} \sim P_{\hat{s}}}\left(\|\nabla D(\hat{s})\|_{2}-1\right)^{2}$ (对Wasserstein GANs不太了解)

生成网络L2 Loss:$L_{H}=\left\|H\left(c\left(s_{t} ; s_{T}\right), l\right)\right\|_{2}$

- 去除产生幻觉的无关元素,例如不改变背景等

Regression Auxiliary Task 回归辅助任务

判别网络的辅助任务是回归真实相对位置:$L_{A}=\left\|\bar{c}\left(\overline{s_{t}}\right)-c\left(s_{t} ; g\right)\right\|_{2}$

- $\bar{c}\left(\overline{s_{t}}\right)$:D预测的相对配置

HALGAN

Loss:$L=L_{D}+\alpha L_{\nabla}+\beta L_{H}+\lambda L_{A}$

- $\alpha=10, \beta=1,\lambda=10$

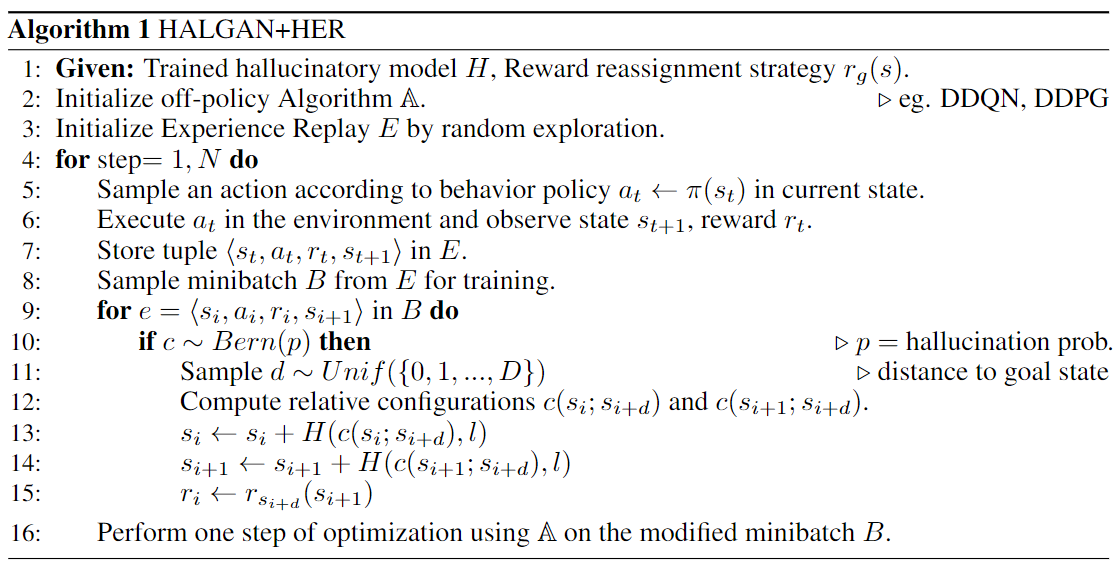

Visual HER Using HALGAN

理论分析

无

实验验证

实验环境:

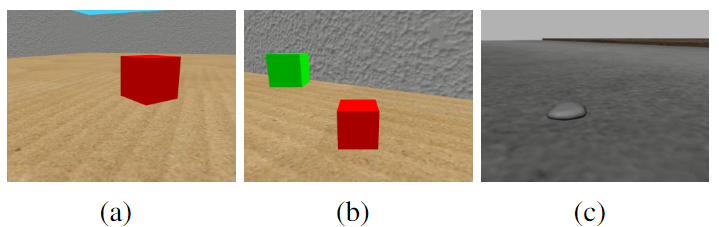

Mini-World:https://github.com/maximecb/gym-miniworld

- 导航到位于封闭式房间的红色盒子

- 导航至红色盒子,通过视觉居中挑选它,然后将放置在绿色盒子处

TurtleBot2 装备一个Gazebo模拟的RGB照相机:

- 智能体通过视野的靠近和居中来捡起在路上随机分散的鹅卵石

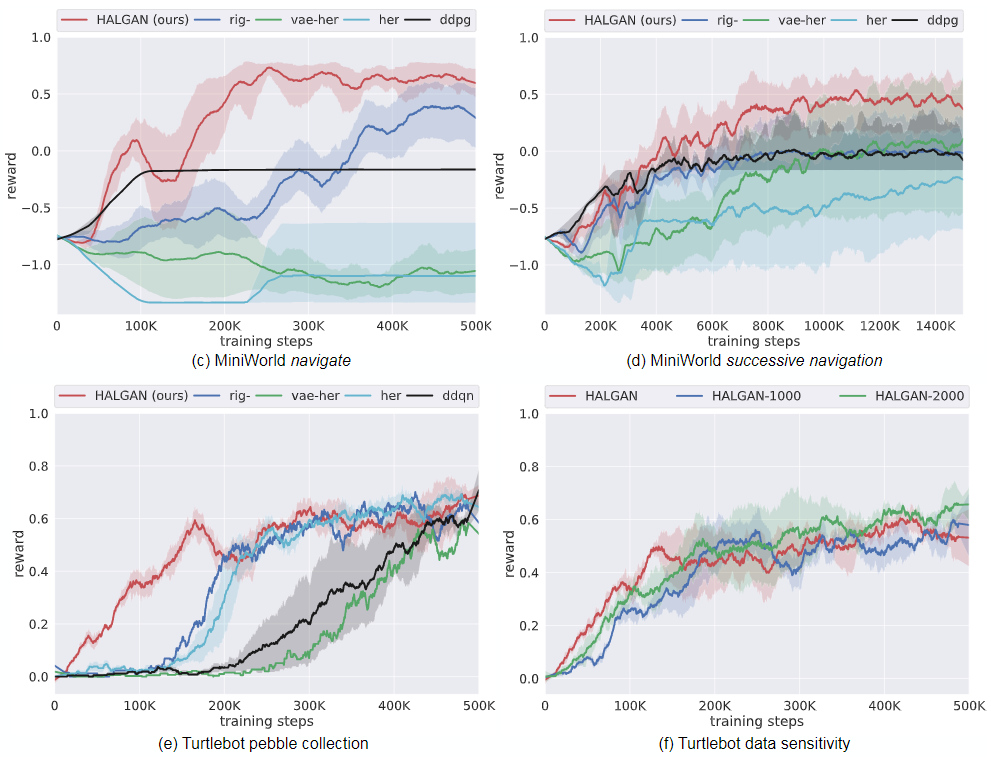

Baseline:

- her:a naive extension of HER

vae-her:将失败轨迹的最后一帧作为目标状态,使用训练的VAE重塑轨迹过程中的奖励

- RIG使用目标状态和当前状态的隐变量距离差计算一个dense reward

- 在数据集R和失败轨迹上预训练一个VAE

- rig-:随机从数据集R中选择一个目标状态,计算当前状态到该状态的距离奖励(即只奖励与数据集中目标状态类似的轨迹)

- ddpg:

Ablation:

- HALGAN:训练HALGAN的数据集R大小为6840

- HALGAN-1000:数据集R大小为1000

- HALGAN-2000:数据集R大小为2000

实验结果:

其他思考

- 该文章区别于大部分RL的研究内容,融入了较多视觉领域的知识,博主对CV并不很了解这里不过多评价,本文结合了Hallucinatory GAN和HER算法,实现了以视觉为输入的HER。

- 将原始轨迹人为修改为成功轨迹,通过修改部分图片信息(及文中的Hallucinatory幻觉),所以该文重点为如何更逼真的生成目标图片(轨迹最后一帧),生成指定的轨迹(即目标状态的前序状态)。

- 目前能想到的该方法的适用性较低,只能处理很简单的视觉跟踪任务,具体应用还有待考察。

原文链接:https://proceedings.neurips.cc/paper/2019/file/532b7cbe070a3579f424988a040752f2-Paper.pdf